-

- توسط ENoohi

- 07 October 2023

- مقالات

-

- توسط ENoohi

- 01 October 2023

- مقالات

افرادی که بخشها و تیمهای شما را تشکیل میدهند، هسته اصلی کل سازمان شما هستند. مراقبت از هر فردی که مدیریت میکنید باید در راس اولویتهای شما باشد تا همزمان روحیه فردی را تقویت کرده و محیطی بردبارتر و کارآمدتر ایجاد کنید.

اما علیرغم اهمیت آن، رفتار سمی همچنان راه خود را در محل کار پیدا میکند.

برای مبارزه با این فرهنگ سمی، کاترین متیس، مدیرعامل و بنیانگذار Civility Partners، در ارائهاش با عنوان «همپیمان برای ایجاد یک محل کار فراگیر»، راههایی را برای شناسایی رفتار سمی در افرادی که مدیریت میکنید و همچنین نکاتی را برای از بین بردن مؤثر سمیت به طور کامل از طریق به چالش کشیدن سوگیریها بیان کرد.

رفتار سمی چیست؟

به عبارت ساده، رفتار سمی هر نوع رفتاری است که باعث آسیب شود. برای بسیاری، کلمه "سمی" بزرگ به نظر میرسد، گویی فقط در مورد اعمال افراطی مانند آزار و اذیت پرخاشگرانه صدق میکند، اما سمی بودن در یک طیف وجود دارد. این طیف با رفتار انحصارگرایانه، بیادبی، تعدی و یا تجاوزات خرد، درگیری، شایعات و طعنه و کنایه شروع میشود و تا حد قلدری، رفتار توهینآمیز، آزار و اذیت، تبعیض و توهین که اشکال بدتر آن هستند ادامه مییابد. اگر اجازه داده شود این رفتار از کنترل خارج شود، گاهی ممکن است حتی به خشونت تبدیل شوند.

آگاهی از درجات مختلف رفتار سمی که ممکن است در میان اعضای تیم شما وجود داشته باشد به شما این امکان را میدهد که از بدتر شدن رفتار و ایجاد درگیریهای واقعی برای تیم خود جلوگیری کنید. در واقع، متیس رفتارهای «سطح پایینتر» و «کممضر» را رایجترین و نگرانکنندهترین رفتارها میداند، زیرا اغلب موارد مدیران برای پرهیز از مدیریت خرد (احتمالی)، توجه زیادی به آنها نمیکنند. به خود و تیمتان آموزش دهید که چگونه بیشتر مراقب این رفتارها باشید و اهمیت مطرح نمودن رفتارهای سمی در هنگام مشاهده سمیت در محل کار را بیان کنید.

سه راه برای مبارزه با یک فرهنگ سمی

به گفته موسسه بهداشت مک کینزی، دلیل اصلی تجربه فرسودگی شغلی کارگران، فرهنگ کاری سمی است. تجربه فرسودگی شغلی با عوارض جانبی زیادی همراه است، به ویژه کمبود انرژی، به ویژه در محل کار. هر چه فرد انرژی کمتری داشته باشد، احتمال بیشتری دارد که بر غریزه و تعصب تکیه کند. این میتواند یک چرخه دائمی ایجاد کند که اساساً باعث افزایش سمیت میشود. اما با هدف قرار دادن خاص سوگیری و نقش آن در این فرآیند، یک سازمان به راحتی میتواند تغییرات مثبت را مشاهده کند. بیش از 200 نوع سوگیری وجود دارد که هر فرد ممکن است داشته باشد، بنابراین به جای تعریف راههایی برای هدف قرار دادن و مبارزه با هر سوگیری احتمالی، متیس سه راه کلی برای مبارزه با آنها ارائه کرد.

- مطمئن شوید که شما و تیمتان میتوانید بپذیرید که در پسزمینه مغزتان اتفاقات ریشهای رخ میدهد. بدون اراده جدی برای یادگیری و توجه به آنها، آن سوگیریها حتما در مسیر این راه قرار میگیرند.

- از سوگیریهایی که هنگام احساس فرسودگی ظاهر میشود آگاه باشید و وقتی با این احساس مواجه شدید از تصمیمگیریهای بزرگ اجتناب کنید. این ممکن است به معنای به تعویق انداختن تصمیمگیری در مورد اینکه چه کسی را استخدام کنیم یا چه کسی را ارتقا دهیم تا زمانی که احساس فرسودگی شغلی از بین برود، باشد. در مورد اینکه نمیتوانید در یک زمان معین تصمیم منطقی بگیرید، جلودار باشید، و وقتی تصمیمی را گرفتید، از دیگران بازخورد بگیرید تا مطمئن شوید که تصمیم شما منطقی است و هیچ زمینهای وجود ندارد که تعصبات شما در آن رخ دهد.

- <دوستان پاسخگو> در تیم خود ایجاد کنید تا در صورت آشکار شدن تعصبات یکدیگر را کمک کنند.

-

- توسط ENoohi

- 27 September 2023

- اخبار

تاریخ خبر: 29/06/1402

دادههای گردآوری شده توسط satellitemap.space نشان میدهد که Starlink (یک مجموعه ماهوارهای که توسط شرکت هوافضا SpaceX اداره می شود) 212 ماهواره را در بازه 18 جولای تا 18 سپتامبر از دست داده است.

دادهها نشان میدهد که تعداد ماهوارههای سوخته در طول سه سال گذشته به طور پیوسته افزایش یافته است، اما از ماه جولای یک جهش قابل توجه را در این خصوص میتوان مشاهده کرد.

اینکه این ماهوارهها قرار بود از مدار خارج شوند یا اینکه سوختن آنها در نتیجه یک شکست بوده است، مشخص نیست. (ماهوارهها پس از طول عمر مفید خود از مدار خارج میشوند، به سمت زمین سقوط میکنند و در جو میسوزند.) سایبرنیوز برای پیگیری این مورد با اسپیس ایکس تماس گرفته اما پاسخی دریافت نکرده است.

برخی از کارشناسان صحت اطلاعات ارسال شده در وب سایت ردیاب را زیر سوال بردند و گفتند که به نظر میرسد اعداد به طور غیرمعمول بالا هستند. اما به گفته satellitemap.space، دادهها بر اساس اطلاعات ردیابی عمومی منتشر شده در space-track.org و سایر سایتها است.

اسپیس ایکس پرتاب ماهوارههای Starlink را در سال 2019 آغاز کرد. از آن زمان تاکنون بیش از 5000 ماهواره به مدار پایینی زمین فرستاده شده است. از این تعداد، حدود 4500 ماهواره فعال هستند.

ماهوارههای استارلینک به گونهای طراحی شدهاند که در پایان چرخه حیات خود، یعنی تقریباً پنج سال، در جو زمین بسوزند.

همچنین احتمال دارد ماهوارهها در برابر طوفانهای الکترومغناطیسی آسیب پذیر بوده باشند، زیرا در تابستان امسال با ورود خورشید به دورهای از فعالیتهای شدید، شعلههای خورشیدی قوی ثبت شده است.

رویدادهای مخرب خورشیدی قبلاً هم Starlink را تحت تأثیر قرار داده است. در فوریه سال گذشته، اسپیس ایکس اعلام کرد که 40 ماهواره جدید را اندکی پس از پرتاب به دلیل طوفان الکترومغناطیسی از دست داده است. محاسبات هزینه پرتاب موشکها نشان میدهد که به طور بالقوه حدود 100 میلیون دلار خسارت به شرکت وارد شده است.

منبع: https://cybernews.com/

-

- توسط ENoohi

- 23 September 2023

- اخبار

الهام طبسی دانشمند ایرانی-آمریکایی توسط مجله تایم به عنوان یکی از 100 فرد تاثیرگذار در هوش مصنوعی (AI) شناخته شد.

طبسی که در ایران متولد و بزرگ شده، میگوید همیشه آرزوی دانشمند شدن را داشته است. او فارغالتحصیل رشته الکترونیک از دانشگاه صنعتی شریف در تهران است. در سال 1994 برای ادامه تحصیل به آمریکا مهاجرت کرد و پنج سال بعد در مؤسسه ملی استاندارد و فناوری آمریکا (NIST) در پروژههای مختلف یادگیری ماشینی و بینایی رایانهای (از مباحث هوش مصنوعی) با کاربرد ارزیابی بیومتریک و استانداردها مشغول به کار شد.

او در اوایل کار خود، طراح اصلی کیفیت تصویر اثر انگشت NIST (NFIQ) بود. NFIQ اکنون یک استاندارد بین المللی برای اندازهگیری کیفیت تصویر اثر انگشت است و توسط FBI و وزارت امنیت داخلی به کار گرفته شده است.

نزدیک به پنج سال پیش، NIST اقدام به ساخت برنامهای برای توسعه سیستمهای هوش مصنوعی قابل اعتماد و مسئولیتپذیر کرد. این الهام طبسی، مهندس برق و رئیس کارکنان آزمایشگاه فناوری اطلاعات مؤسسه بود که مباحث تأثیر هوش مصنوعی را از اصول و تئوری به سیاستهای کاربردی تبدیل کرد.

پیشنهاد او به طور قابل توجهی نتیجه داد. پس از آنکه تیم طبسی در مورد امنیت و سوگیری هوش مصنوعی تحقیقات خودش را آغاز کرد، کنگره NIST را موظف کرد تا به عنوان بخشی از قانون مجوز دفاع ملی (NDAA)، یک چارچوب داوطلبانه مدیریت ریسک برای سیستمهای هوش مصنوعی قابل اعتماد در سال 2021 ایجاد کند.

او به این تلاش ادامه داد و در ژانویه 2023 از چارچوب نهایی رونمایی کرد. این چارچوب به کاربران و توسعهدهندگان هوش مصنوعی در تحلیل و رسیدگی به خطرات مرتبط با سیستمهای هوش مصنوعی و در عین حال ارائه دستورالعملهای کاربردی برای رسیدگی و به حداقل رساندن چنین خطراتی کمک میکند.

فهرست 2023 TIME100 AI مجله تایم همچنین شامل 99 نفر دیگر میباشد. شامل مدیران عامل، بنیانگذاران، از جمله:

Elon Musk of xAI, Sam Altman of OpenAI, Andrew Hopkins of Exscientia, Nancy Xu of Moonhub, Kate Kallot of Amini, Pelonomi Moiloa of Lelapa AI, Jack Clark of Anthropic, Raquel Urtasan of Waabi, Aidan Gomez of Cohere

منبع: خبرگزاری آنا- مجله تایم https://time.com/, https://ana.press/#هوش مصنوعی #الهام طبسی #AI#بایگانی الکترونیکی

-

- توسط ENoohi

- 29 August 2023

- اخبار

تاریخ خبر: 06/06/1402

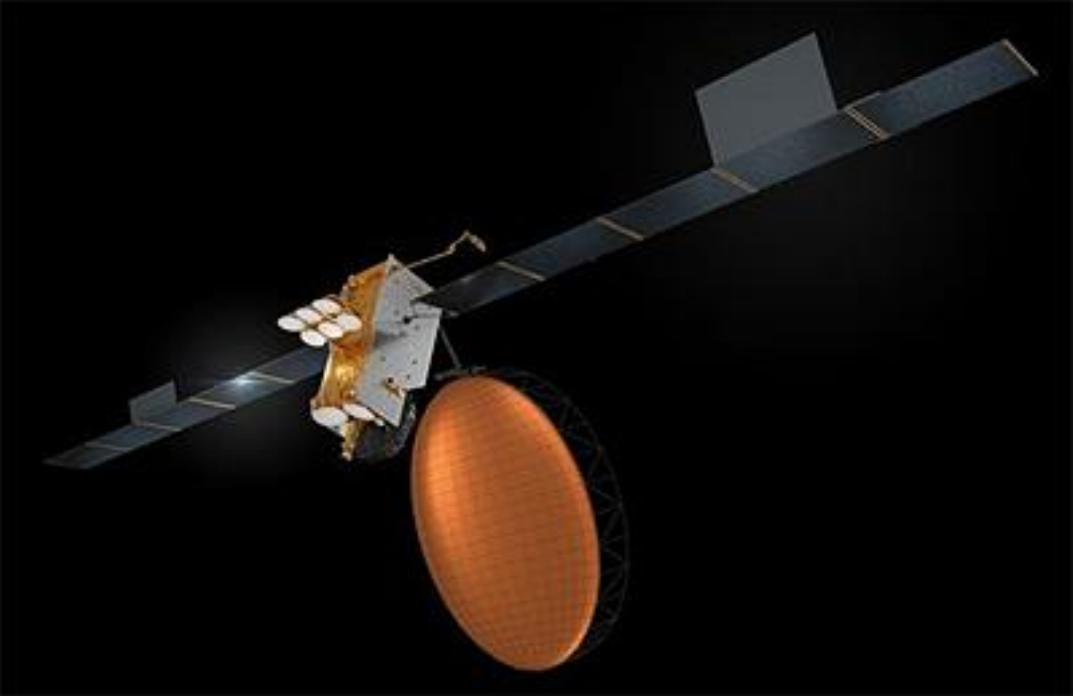

به گزارش ViaSAT در بعدازظهر پنجشنبه 02/06/1402، ممکن است ماهواره Inmarsat-6 F2 به دلیل یک ناهنجاری در زیرسیستم برق که در حین بالا بردن مدار رخ داده است، دچار شکست کامل شود . Viasat و سازنده ایرباس در حال رسیدگی به این مشکل و بررسی امکان عملکرد درست این ماهواره در آینده، مطابق با ماموریت آن هستند.

ایرباس با اشاره به اینکه هرگز یک ماهواره مخابراتی در مدارش از کار نیفتاده است، تاکید کرد که مشکل پیشآمده، یک "رویداد بیسابقه" است.

اما ظاهراً این امر برای Viasat بیسابقه نیست، این دومین شکست ماهوارهای اخیر این شرکت میباشد. پنلهای خورشیدی ماهواره پرچمدار این اپراتور (ViaSat-3) مشکل دارد، اما Viasat هنوز آن را به عنوان یک شکست اعلام نکرده است.

در مورد I-6 F2 که SpaceX در ماه فوریه به فضا پرتاب کرد، Viasat گفت که انتظار ندارد بر چشمانداز مالی شرکت برای درآمد و رشد EBITDA (درآمد قبل از بهره، مالیات و استهلاک) تأثیر بگذارد. هدف از این ماهواره افزایش ماهوارههای باند L اینمارست و تکمیل ظرفیت و ارائه پوشش اضافی بود. مارک دانکبرگ، رئیس هیئت مدیره و مدیر عامل Viasat در این خصوص بیان کرد: "ماموریت اولیه I6 F2 اساساً ارائه باند L پشتیبان و 4Gbps ظرفیت اضافی باند Ka، جهت استقرار و راه اندازی یک شبکه انعطاف پذیر و افزونه، بوده."

این ماهواره بر اساس فضاپیمای ایرباس Eurostar E3000، با یک آنتن باند L و شش آنتن باند Ka با بیمهای متعدد ساخته شده است. ضمناً ماهواره دوقلوی آن، I-6 F1، به درستی کار میکند.

Viasat اظهار کرد: "هزینههای ساخت و پرتاب ماهواره بیمه شده است و انتظار میرود موقعیتهای مالی بهبود یابد." پیرو آن در بیانیه روز پنجشنبه اطمینان داد که این شکست تأثیری بر ترازنامه آن شرکت نخواهد داشت. گرچه در صورتی که هر دو ماهواره I-6 F2 و ViaSat-3 دچار خرابی شوند، اپراتور به طور بالقوه در آینده نزدیک دو ادعای بیمه خواهد داشت.

Viasat سه ماهواره باند L دیگر، fleet Inmarsat-8، در دست ساخت دارد تا خدمات امنیتی سراسری این شرکت را تقویت کند. همچنین در رابطه با ظرفیت باند Ka، کنسرسیوم Viasat و Inmarsat به شرکت ترکیبی از 11 ماهواره باند Ka و امکان دسترسی به ماهواره های یکدیگر را میدهد. هفت ماهواره Ka-band دیگر نیز به منظور توسعه خدمات متحرک سراسری این شرکت در دست ساخت است.